Zgodnie z oczekiwaniami, Nvidia zaprezentowała na GTC 2024 nową architekturę Blackwell. Dzięki chipowi B200 i platformie GB200 producent wkracza w nowe sfery

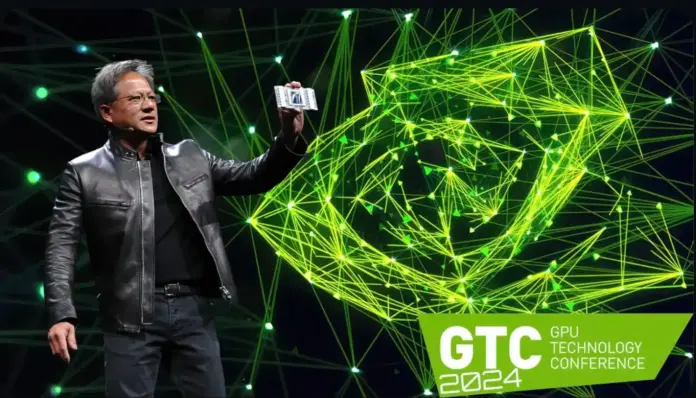

Zgodnie z oczekiwaniami, Nvidia zaprezentowała nową architekturę Blackwell na trwającejGTC 2024 (GPU Technology Conference)w poniedziałek wieczorem, obiecując wyznaczenie nowych standardów.

Jak wyjaśnił Jensen Huang, CEO Nvidii, ma to zwiastować „nową erę generatywnej sztucznej inteligencji”. Na jej czele stoi układ B200, który zastępuje poprzednie flagowce H100 i GH100 z generacji Hopper

Imponująca specyfikacja techniczna (patrz poniżej) sugeruje, że główni klienci, tacy jak Amazon i Microsoft, z odpowiednim popytem i budżetem, będą ustawiać się w kolejce do Nvidii, aby zdobyć jak najwięcej tych chipów.

Najważniejsze rzeczy w pigułce

- Nvidia prezentuje nową architekturę Blackwell dla generatywnej sztucznej inteligencji na GTC 2024.

- Chip B200 zastępuje flagowe modele H100 i GH100 i oferuje lepszą wydajność i efektywność energetyczną.

- Procesor graficzny jest oparty na procesie produkcyjnym 4 nm i ma 208 miliardów tranzystorów.

- Superukład GB200 łączy w sobie procesory Grace i układy graficzne Blackwell, oferując niezwykle wysoką moc obliczeniową.

Dane techniczne układu Nvidia B200

Procesor graficzny został opracowany w oparciu o proces produkcyjny 4NP – specjalny proces produkcyjny 4 nm zaprojektowany dla Blackwell przez tajwańskiego producenta chipów TSMC.

Sam układ B200 jest konstrukcją dwudyskową. Dwa wbudowane chipy komunikują się za pośrednictwem łącza slide-to-die z prędkością do 10 TByte na sekundę i dlatego nie powinny mieć żadnych wad w porównaniu z procesem MCM (Multi Chip Module), który jest używany głównie przez AMD.

W karcie B200 znajduje się łącznie 208 miliardów tranzystorów Według Nvidii, teoretyczna moc obliczeniowa przedstawia się następująco:

- FP8: do 20 PetaFLOPS

- FP16: Do 10 PetaFLOPS

- FP32: Do 5 PetaFLOPS

Według Huanga powinno to zaowocować około czterokrotnym wzrostem wydajności w szkoleniu AI i 30-krotnym wzrostem wydajności we wnioskowaniu AI. W międzyczasie wydajność energetyczna powinna zostać poprawiona 25-krotnie.

Po stronie pamięci, Nvidia B200 współpracuje z 192 GB pamięci HBM3e, przepustowość powinna wynosić do 8 TByte/s.

„Grace Blackwell” jako nowy superchip

Nowy chip stanowi również podstawę dla superukładu „Grace Blackwell” o nazwie GB200, który będzie wykorzystywany przede wszystkim we własnym komputerze Nvidii NVL72 oraz niestandardowych rozwiązaniach.

Zgodnie z nazwą, Grace Blackwell GB200 to hybrydowe rozwiązanie składające się z procesora Grace z 72 rdzeniami Neoverse V2 od producenta Arm oraz dwóch przedstawionych układów graficznych B200 – pojedynczy chip GB200 ma więc pod tym względem cztery matryce.

W wymienionym powyżej komputerze NVL72 zastosowano 36 procesorów Grace wraz z 72 układami graficznymi Blackwell (a co za tym idzie 144 matryce Blackwell), co daje następujące szalone dane techniczne:

- Procesor: 2592 rdzenie ARM Neoverse V2

- Pamięć: Do 17 TB pamięci RAM LPDDR5X

- 72 procesory graficzne Blackwell z 13,5 TB pamięci HBM3e

Moc obliczeniowa - FP4: do 1 440 PetaFLOPS

- FP8 moc obliczeniowa: Do 720 PetaFLOPS

- FP16 moc obliczeniowa: Do 360 PetaFLOPS

Dzięki NVLink, który obiecuje przepustowość do 130 TByte na sekundę, superkomputer NVL72 powinien zachowywać się jak pojedynczy, ogromny procesor graficzny

Łącznie do 576 procesorów graficznych może być połączonych w takiej domenie NVLink – według Huanga, całkowita moc obliczeniowa powinna być wystarczająca do przetwarzania dużych modeli językowych (LLM) z bilionami parametrów.

Zakładany pobór mocy jest odpowiednio wysoki: pojedynczy superukład GB200 ma wymagać do 2700 watów.

Pierwsi klienci biznesowi już ustawiają się w kolejce Platforma AI powinna być dostępna dla partnerów biznesowych w ciągu roku. Nvidia wyraźnie wspomina o dostawcach usług w chmurze, takich jak AWS, Google Cloud, Microsoft Azure i Oracle Cloud Infrastructure, którzy, co nie jest zaskoczeniem, wykazują zainteresowanie architekturą Blackwell. Jak wyjaśnia Huang, Nvidia stoi w obliczu „najbardziej udanej premiery w historii firmy” z Blackwell.